Meta发布AI基准测试工具FACET 用于评估 AI 模型的“公平性”

要点:

Meta发布了名为FACET的数据集,用于探测计算机视觉模型对某些“类别”人群的偏见。

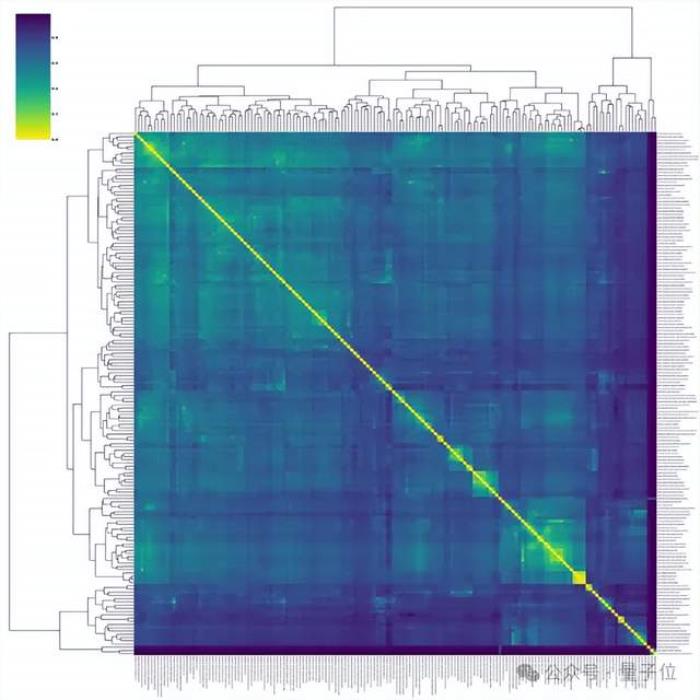

FACET包含32000张图片,50000人的图像,标注了职业和活动“类别”,以及人口统计和身体特征。

FACET可用于测试模型在不同人口属性上的分类、检测、分割和定位任务的公平性。

新火种(xhz.cn) 9月1日 消息:Meta今天发布了一个新的AI基准测试,名为FACET,旨在评估在照片和视频中对人和物体进行分类和检测的AI模型的“公平性”。

FACET由32,000张包含50,000个人标签的图像组成,这些标签由人类注释者标注。除了与职业和活动相关的类别,如“篮球运动员”、“DJ”和“医生”,还包括人口统计和身体属性,使Meta能够对针对这些类别的偏见进行“深度”评估。

Meta在一篇与TechCrunch共享的博客文章中写道:“通过发布FACET,我们的目标是让研究人员和从业者能够进行类似的基准测试,以更好地理解他们自己的模型中存在的偏见,并监控所采取的缓解措施对这些偏见的影响。” “我们鼓励研究人员使用FACET来评估其他视觉和多模态任务的公平性。”

注:图片由midjourney生成

当然,探测计算机视觉算法偏见的基准测试并不是什么新鲜事。Meta自己几年前就发布过一个基准测试,用于揭示计算机视觉和音频机器学习模型中的年龄、性别和肤色歧视。许多研究已经对计算机视觉模型进行了评估,以确定它们是否存在针对某些人群的偏见。

此外,事实上,Meta 在负责任的人工智能方面并没有最好的记录。去年年底,Meta不得不撤下一款AI演示,因为它编写了种族主义和不准确的科学文献。有报道称,该公司的AI伦理团队基本没有作用,而它发布的反AI偏见工具被形容为“完全不足够”。同时,学术界指责Meta加剧了其广告服务算法中的社会经济不平等,并在其自动审查系统中表现出对黑人用户的偏见。

但Meta声称FACET比之前所有的计算机视觉偏见基准测试都要深入——能够回答这样的问题:“当被感知的性别表现具有更多传统男性特征时,模型是否在将人们分类为滑板运动员方面做得更好?”以及“当头发卷曲程度与直发相比时,任何偏见都会放大吗?”

为了创建FACET,Meta让上述注释者为32,000张图像中的每张人物图像标注人口统计属性(例如图片中人物的感知性别表现和年龄组)、额外的身体属性(例如肤色、光线、纹身、头饰和眼镜、发型和面部毛发等)以及类别。他们将这些标签与其他来自Segment Anything1Billion的关于人、头发和服装的标签结合。Segment Anything1Billion是Meta设计的用于训练计算机视觉模型从图像中“分割”或隔离物体和动物的数据集。

Meta告诉我,FACET图像的来源是Segment Anything1Billion,而这些图像则从“照片提供商”处购买。但目前还不清楚图片中所描绘的人是否知道他们的图片将被用于这个目的。此外——至少在博客文章中——还不清楚Meta是如何招募注释者团队的,以及他们得到了多少工资。

从历史上看,甚至在今天,许多为AI培训和基准测试标注数据集的注释者来自发展中国家,收入远低于美国的最低工资标准。就在本周,《华盛顿邮报》报道,规模最大、融资最充足的注释公司之一Scale AI向工人支付的工资极低,经常拖欠或扣发工资,并为工人提供寻求救济的渠道很少。

在描述FACET如何诞生的白皮书中,Meta表示注释者是“经过培训的专家”,他们来自包括北美(美国)、拉丁美洲(哥伦比亚)、中东(埃及)、非洲(肯尼亚)、东南亚(菲律宾)和东亚(台湾)等多个地理区域。Meta表示,它使用了来自第三方供应商的“专有注释平台”,并按照每个国家一小时的工资标准向注释者提供报酬。

撇开FACET可能存在问题的出处不谈,Meta表示该基准测试可用于探测不同人口统计属性下的分类、检测、“实例分割”和“视觉基础”模型。

作为测试用例,Meta将其自己的DINOv2计算机视觉算法应用于FACET,该算法已于本周开始商业使用。Meta表示,DINOv2发现了几种偏见,包括对某些性别表现的人的偏见以及对典型地将女性照片识别为“护士”的可能性的偏见。

在博客文章中,Meta写道:“DINOv2预训练数据集的准备过程可能无意中复制了为策展选择的参考数据集中的偏见。我们计划在未来的工作中解决这些潜在的不足之处,并相信基于图像的策展也可以帮助避免因使用搜索引擎或文本监督而产生的潜在偏见。”

没有完美的基准测试。值得称赞的是,Meta承认FACET可能无法充分捕捉现实世界的概念和人口群体。它还指出,由于自FACET创建以来,许多职业形象可能已经发生了变化。例如,在COVID-19大流行期间拍摄的FACET中的大多数医生和护士都佩戴了比大流行前更多的个人防护装备。

在白皮书中,Meta写道:“目前我们不打算更新此数据集。我们将允许用户标记任何可能令人反感的内容,并在发现时删除这些内容。”

除了数据集本身外,Meta还提供了一个基于网络的数据集浏览器工具。要使用该工具和数据集,开发人员必须同意不将其用于训练计算机视觉模型——而只用于评估、测试和基准测试。

- 免责声明

- 本文所包含的观点仅代表作者个人看法,不代表新火种的观点。在新火种上获取的所有信息均不应被视为投资建议。新火种对本文可能提及或链接的任何项目不表示认可。 交易和投资涉及高风险,读者在采取与本文内容相关的任何行动之前,请务必进行充分的尽职调查。最终的决策应该基于您自己的独立判断。新火种不对因依赖本文观点而产生的任何金钱损失负任何责任。

新火种

2023-09-01

新火种

2023-09-01